NUMAとは?サーバーの性能向上を支える技術

ICTを知りたい

『NUMA』って、どういう仕組みなんですか? たくさんのCPUを使うときに関係するみたいだけど、よくわかりません。

ICT研究家

良い質問ですね。『NUMA』は、CPUがたくさんあってもメモリーへのアクセスをスムーズにする仕組みです。 例えば、たくさんの人が住んでいるマンションで、全員が一つの郵便受けを共有するよりも、各部屋に郵便受けがあった方が便利ですよね?

ICTを知りたい

確かに、そうすると遠くまで取りに行かなくて済みますね! でも、NUMAでは全部のCPUが全部のメモリーを使えるわけではないんですよね?

ICT研究家

その通りです。NUMAでは、それぞれのCPUに近い場所にあるメモリーは速くアクセスできますが、遠い場所にあるメモリーへのアクセスは少し遅くなります。 近くの郵便受けはすぐに確認できるけど、管理人室にある郵便受けは確認に行くのに時間がかかるイメージですね。

NUMAとは。

「情報通信技術でよく聞く『NUMA』って何か説明しましょう。NUMAは、複数の処理装置を使うコンピューターの設計方法の一つです。日本語では『共有メモリー型マルチプロセッシング』と呼びます。NUMAは、コンピューターの処理能力を上げやすく、処理装置が増えても記憶装置へのアクセスが効率的に行えます。

従来のSMPと呼ばれる設計方法では、すべての処理装置が一つの記憶装置を共有していました。そのため、処理装置が増えるにつれて記憶装置へのアクセスが集中し、処理速度が遅くなる問題がありました。

一方、NUMAでは、処理装置ごとに専用の記憶装置があります。それぞれの処理装置は自分の専用の記憶装置に同時にアクセスできるため、処理装置が増えても記憶装置へのアクセスが遅くなりません。そのため、コンピューター全体の処理能力を高く保てます。

ただし、NUMAは自分の専用の記憶装置にあるデータしか高速にアクセスできません。他の処理装置の記憶装置にあるデータを使う場合は、低速なアクセスになってしまいます。このように、NUMAではアクセス速度が異なる複数の記憶装置を使うため、『Non-Uniform(均一でない)』という言葉が使われています。」

NUMAの概要

– NUMAの概要NUMA(Non-Uniform Memory Access)は、日本語では「共有メモリー型マルチプロセッシング」と呼ばれる技術で、高性能サーバーなどで処理能力を向上させることを目的としています。複数のCPUを用いるシステムにおいて、従来のSMP(対称型マルチプロセッシング)では、すべてのCPUが一つのメインメモリーを共有していました。しかし、CPUの数が増加するにつれて、この一つのメモリーへのアクセスが集中し、処理速度の低下が課題となっていました。NUMAは、この課題を解決するために考案されました。NUMAでは、複数のCPUとメモリーをグループ化して、それぞれのグループが独立したメモリ空間を持つように構成します。各CPUは、自身のグループ内のメモリーには高速にアクセスできますが、他のグループのメモリーにアクセスする場合は、ネットワークを経由するため、アクセス速度が低下します。このように、NUMAはメモリーへのアクセス速度が均一ではないため、「非均一メモリーアクセス」と呼ばれます。しかし、CPUが自身のグループ内のメモリーに優先的にアクセスすることで、メモリーへのアクセス集中を緩和し、全体的な処理能力の向上を実現しています。NUMAは、大規模なデータ処理や仮想化技術など、高い処理能力が求められるシステムで広く採用されています。

| 項目 | 内容 |

|---|---|

| 技術名 | NUMA (Non-Uniform Memory Access) 日本語では「共有メモリー型マルチプロセッシング」 |

| 目的 | 高性能サーバーなどで処理能力を向上させる |

| 従来の問題点(SMP) | CPU数増加に伴い、単一メインメモリーへのアクセス集中が発生し、処理速度が低下 |

| NUMAの解決策 | 複数のCPUとメモリをグループ化し、各グループが独立したメモリ空間を持つ構成にする |

| アクセス速度 | CPUは自身のグループ内のメモリに高速アクセス、 他のグループのメモリにはネットワーク経由でアクセスするため速度低下 |

| メリット | CPUが自身のグループ内のメモリに優先的にアクセスすることで、メモリへのアクセス集中を緩和し、全体的な処理能力を向上 |

| 用途 | 大規模データ処理、仮想化技術など、高い処理能力が求められるシステム |

CPUごとにメモリを分散

複数のCPUを搭載したサーバーにおいて、処理能力を最大限に引き出すために、メモリ構成は重要な要素となります。従来のシステムでは、全てのCPUが一つのメモリを共有していました。しかし、CPUの数が増えるにつれて、メモリへのアクセスが競合し、処理速度が低下するという問題が生じていました。

NUMA(Non-Uniform Memory Access)は、このような問題を解決するために考案されたメモリ構成です。NUMAの特徴は、それぞれのCPUが独立したメモリを持つ点にあります。CPUは、まず自分の担当範囲であるローカルメモリにアクセスします。ローカルメモリへのアクセスは高速であるため、従来のように全てのCPUが一つのメモリを共有する方式に比べて、データ処理速度を向上させることができます。

CPUが増えても、メモリへのアクセス競合が軽減されるため、処理能力の低下を抑え、サーバー全体のパフォーマンス向上を実現できます。NUMAは、データベースサーバーや科学技術計算など、大量のデータを扱うサーバーシステムで特に有効です。

| 項目 | 従来のシステム | NUMA |

|---|---|---|

| CPUとメモリの関係 | 全てのCPUが一つのメモリを共有 | 各CPUが独立したメモリを持つ |

| メモリへのアクセス | 全てのCPUが一つのメモリにアクセスするため、競合が発生 | CPUはまずローカルメモリにアクセスするため、競合が軽減 |

| 処理速度 | CPU数増加に伴い、メモリ競合により速度低下 | メモリ競合軽減により、高速処理が可能 |

| メリット | – | CPU数増加による処理能力低下を抑え、サーバー全体のパフォーマンス向上 |

| 活用例 | – | データベースサーバー、科学技術計算など |

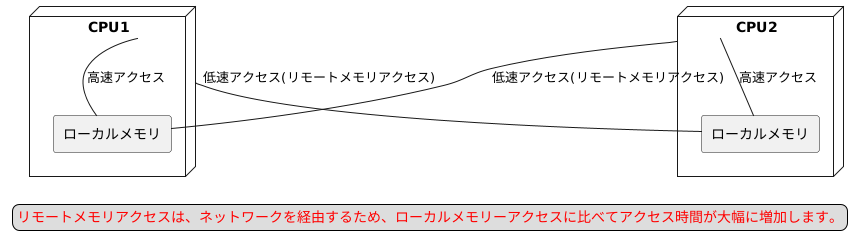

リモートメモリーへのアクセス

コンピュータシステムにおいて、各CPU(中央処理装置)はそれぞれ専用のメモリ領域であるローカルメモリに高速にアクセスすることができます。プログラムの実行に必要なデータはまずローカルメモリ上に配置されるため、CPUは効率的に処理を進めることができます。

しかし、処理に必要なデータが他のCPUのローカルメモリ上に存在する場合もあります。このような場合、CPUはネットワークを介してそのメモリ領域にアクセスしなければなりません。これがリモートメモリーアクセスです。

リモートメモリーアクセスは、ネットワークを経由するため、ローカルメモリーアクセスに比べてアクセス時間が大幅に増加してしまいます。これは、データ転送の遅延やネットワーク帯域幅の制限など、さまざまな要因によって発生します。

NUMA(Non-Uniform Memory Access)は、このようなアクセス速度の異なるメモリを混在させて使用するアーキテクチャです。NUMAでは、CPUはアクセス速度の速いローカルメモリを優先的に使用し、リモートメモリーへのアクセスは必要最小限に抑えることで、システム全体の性能低下を抑制しようとします。

NUMAのメリット

– NUMAの利点NUMA(Non-Uniform Memory Access)は、近年、高性能サーバーやスーパーコンピューターにおいて広く採用されている技術です。その最大の利点は、CPUの数を増やした際に起こりがちな、メモリへのアクセス集中による処理速度の低下を抑え、高い処理性能を維持できる点にあります。従来のシステムでは、全てのCPUが全てのメモリに均等にアクセスしていました。しかしCPUの数が増えると、メモリへのアクセスが集中し、処理速度の低下を招いてしまうという問題がありました。これを解消するために開発されたのがNUMAです。NUMAでは、システム内のメモリを複数の領域に分割し、それぞれのCPUに最も近いメモリ領域を割り当てます。CPUは、まず自分に近いメモリ領域にアクセスするため、従来のように全てのCPUが一つのメモリ領域にアクセスする状況が避けられます。 これにより、メモリへのアクセス集中が緩和され、処理速度の低下を抑制することが可能になります。特に、データベース処理や科学技術計算など、大量のデータ処理が必要な場面において、NUMAの効果は顕著に現れます。これらの処理では、大量のデータに頻繁にアクセスする必要があるため、メモリへのアクセス速度がシステム全体の性能に大きく影響します。NUMAを採用することで、メモリへのアクセス速度が向上し、処理全体を高速化することが可能になります。このように、NUMAはCPUの処理能力を最大限に引き出すことができる技術であり、今後も高性能なコンピューティングシステムにおいて重要な役割を担っていくと考えられています。

| 従来のシステム | NUMA | メリット |

|---|---|---|

| 全てのCPUが全てのメモリに均等にアクセス | メモリを分割し、各CPUに最も近いメモリ領域を割り当て | メモリへのアクセス集中を緩和し、処理速度低下を抑制 |

| NUMAの効果が顕著な場面 | 理由 |

|---|---|

| データベース処理や科学技術計算など、大量のデータ処理が必要な場面 | 大量のデータに頻繁にアクセスするため、メモリへのアクセス速度がシステム全体の性能に大きく影響するため |

NUMAの今後の展望

– NUMAの今後の展望現代社会では、日々生成されるデータ量が爆発的に増加しており、その処理需要は留まることを知りません。このような状況下において、膨大なデータを高速に処理する技術は、様々な分野の進歩に不可欠となっています。その中でも、NUMA(Non-Uniform Memory Access)と呼ばれる技術は、サーバー技術の進化において重要な役割を担っています。従来のサーバーアーキテクチャでは、CPUはすべてのメモリに均等にアクセスできました。しかし、CPUの処理能力が向上するにつれて、メモリへのアクセス速度がボトルネックとなる現象が顕著になってきました。そこで登場したのがNUMAです。NUMAは、複数のCPUとメモリをグループ化し、各CPUが最も近いメモリに高速にアクセスできるようにすることで、メモリへのアクセス遅延を減らし、全体的な処理性能を向上させる技術です。近年では、CPUのマルチコア化、サーバーの大規模化がさらに進展しており、それに伴いNUMAの重要性はますます高まっています。CPUコア数が増加すると、メモリへのアクセス競合が発生しやすくなり、処理性能が低下する可能性があります。しかし、NUMAを採用することで、各CPUが自身のメモリ領域に優先的にアクセスできるため、競合を抑制し、高い処理性能を維持することができます。今後、データ処理量の増加、処理速度の高速化の要求はますます高まり、サーバーシステムには更なる高性能化が求められます。NUMAは、このような高性能サーバーの性能向上に貢献する技術として、今後も進化を続けると期待されています。例えば、NUMAノード間のデータ転送速度の高速化や、NUMA構成の最適化技術の進歩などが期待されます。これらの技術革新により、NUMAは将来のサーバー技術においても重要な役割を果たすと考えられています。

| 項目 | 内容 |

|---|---|

| 背景 | – データ量の爆発的な増加 – 高速なデータ処理技術の需要増加 |

| NUMAとは | – Non-Uniform Memory Accessの略 – CPUとメモリをグループ化し、各CPUが近いメモリに高速にアクセスできるようにする技術 – メモリアクセス遅延の減少、処理性能の向上を目的とする |

| NUMAの重要性 | – CPUのマルチコア化、サーバーの大規模化に伴い増加 – メモリアクセス競合の抑制 – 高い処理性能の維持 |

| 今後の展望 | – データ処理量の増加、処理速度の高速化要求への対応 – NUMAノード間のデータ転送速度の高速化 – NUMA構成の最適化技術の進歩 |